吴雨睿

福州大学至诚学院 福建福州 350002

摘要:随着网络信息量的爆炸式增长,大数据时代的来临,人工智能的不断发展和应用,Python语言在各大行业逐渐展现出明显的优势,显现在处理量大且繁琐的数据时,不仅节约时间,提高工作效率,并且进一步促进行业的发展,更重要的是其语言简单易懂。首先通过使用python语言进行爬取网站,采集最新的招聘信息,得到关于互联网行业的数据,采集完成后将数据存储到本地,确定保存路径,然后对数据信息进行数据预处理,预处理是将数据规范化,最后利用matplotlib库对已经预处理的数据进行数据分析和数据可视化。得出的结果主要是互联网行业的城市大概分布情况、薪酬分布和企业福利、企业所属行业、学历的要求以及工作经验的要求,给人们提供一份互联网行业的需求分析和发展报告。

关键词:互联网行业;网络爬虫;数据分析;数据可视化

前言

随着人工智能和大数据的发展,互联网行业也随之在发展和更新。而网络招聘也随着互联网行业兴起以来成为高效和直接的途径,其中包含了大量人才需求信息数据,这些数据在一定程度上可反映出人才市场的需求趋势和发展特点。

1 大数据特征

大数据,可以顾名思义指巨大海量的数据。其具有的四大特征如下。

(1)Volume的意思是大量,这里表明数据量非常大。

(2)Variety的意思是多样性,这里表明有多种类型的数据。而数据类型则分为结构化数据和非结构化数据这两个部分。前者基于文本类型,后者则涵盖图片、音频及地理位置信息等。

(3)Value的意思是价值,这里表明其价值密度低。也就是说有价值的数据比较少。

(4)Velocity的意思是高速,这里表明指能够快速的对数据进行处理。这也是大数据与传统数据挖掘的最大区别之处。曾经在“数字宇宙”这一报告中,预计了2020年全球数据使用量将达到35.2ZB。而到如今2021年用时间证明了比预计达到的数据使用量还更多,甚至超过了40ZB。因此,对企业来说,能够高效的处理数据信息是非常重要的。

2 前期网络大数据调查

2.1互联网职位调查

互联网职位需求图可以分析出,职能类别的职位是互联网最易招的5种职位,比如人力、行政等基础性管理岗位,这些岗位的在互联网行业中需求不是很大,职能类别相比于其他来说还是比较容易招聘的。由于前段时间新兴职位的兴起,互联网行业最热门的职位是程序员鼓励师,鼓励师主要是负责调解团队成员之间产生的矛盾,因为程序员之间都不太擅长沟通,所以程序员励志师的兴起是有原因的。有两个方面的原因,一方面来说互联网行业内企业对该职位一般都是低要求,但是有需要这么一类人在,另一方面由于工作职责要求比较轻松有趣,没有压力,所以吸引了很多年轻女性前来应聘。

2.1.2互联网热门和冷门职位

热门职位的计算公式为热门程度=平均月薪*发布职位数/已招到职位数,月薪是求职者都比较关心的,根据这个计算公式,计算出互联网行业排名较为靠前的职位,主要是架构师、项目管理、产品经理、数据工程师和研发工程师。通过互联网热门职位图看出,技术岗位职位就已经占了四名,所占比例之高体现了科技发展之快,所以高要求的技术能力需求使架构师成为了最热门的职业,薪酬也是岗位需求热门的原因之一,技术岗位的高薪酬带动了技术岗位的需求。

冷门职位的计算公式为冷门程度=平均月薪*发布职位数/已招到职位数,通过公式计算出排名最低的职位,然后分析都属于哪些类别,是哪些职位。由图知这些职位均属于职能类别,主要有编辑、客服、前台、行政和出纳,特别是财务这块的业务往往不受重视,可能是现在国家鼓励创业,有创业补贴,所以很多互联网企业正处在初创期,互联网行业最过剩的职位当属于出纳,其需求量最少,因为互联网企业要么外包给财务公司,要么某个人员兼任。

2.1.2年薪分布和发展阶段分布

通过年薪和发展阶段分布图的分析,可知,工作前5年里,互联网行业中人才需求较多的职位,当属于技术和产品类别,年薪较高推动了职位需求,职位需求的增多也使薪酬提高了,比如技术和产品类别的职位,而工作5年后,明显发生了变化,运营类别比其他类别发展更好,从年薪的涨幅可以看出,后段时期更是超过了做产品的人员,说明工作年限越长,运营类别的岗位比技术类和产品类的发展更好。前10年里,前期薪酬相对较低的大部分是职能部门的人员,当工作达到10年以上,市场的薪酬能和设计相关职位人员达到同一层次。

通过数据信息筛选,选取了排名前五的城市,是互联网企业最集中的地方,由分析,比例最多的是上海的非天使轮公司,排名第一,上市公司比例也最高,排名第二,表明上海的创业公司发展还不错,适合创业人员,想要创业的优秀人员可以考虑以上海作为创业基地。

根据分析互联网企业所属行业图,研究每日招聘的平均岗位数,企业每月的平均月薪,针对这些关键信息,分析出企业所属行业的具体发展,年薪、岗位数和公司规模对每个行业互联网企业来说都是属于代表性的信息,所以对其进行了统计分析是非常有必要的,企业发展情况可以一目了然。

2.2数据采集

本文利用Python语言按网络爬虫技术来获取数据源,使用广度优先的策略可以高效快速获取到所需的大量数据,即先根据关键词确定爬取的信息链接,接着对前程无忧网站中网页的起始链进行依次爬取,选择其中的一个网页链接读取,读取完网页链接,继续读取此链接中的所有相关页面。广度优先是网络爬虫技术较常用的采集策略,既方便又快速,相比于其他策略,其特点是利用多个采集器并行处理,从而提高抓取的速度。

程序在读取的网页时,网页中有一些不是我们需要的信息、没由价值意义的数据,如广告等垃圾信息。利用正则化匹配方法提取课题需要的数据,让数据更加的规范化。

岗位信息可利用网页本身的标签、属性和字段进行获取,都是较简洁清晰的方法,分析前程无忧网站某条信息的代码,代码中一般都有标签之类的数据,比如岗位部分信息存储在标签下,URL就存储着其他字段的岗位信息,所以不同的类别分布在不同的地方,分布在自己所属位置,分工明细,像关于职责描述、职位类别等字段都存在具体的URL中,以便采集。

2.3数据的预处理

2.3.1数值信息规范化

规范化是采集信息实行的第一步预处理,规范化由其重要,例如薪资字段,在采集初始时,数据是混乱的,没有经过预处理的数据,如果采用数据分析,那么出来数据是不健全的,也有可能分析不了。像有的是千/月,有的是万/年,分析时只会识别确定的字段,没有统一的式样,是难以支撑后面的数据研究。地区字段也是需要规范化的,在信息中有些包含所属区,有些则没有,在分析时可能因为所属区的有无,导致数据错乱,无法得出结果,所以需统一规划到城市类别上。在经验上,要求的统分也是需要整理,比如将“一年”和“两年”统一划分为一个层次“1-2年”。

2.3.2岗位类型的聚集

由于在采集数据的过程中,采集数据的代码都是大类类别来采集的,然后采集的岗位类型数据字段一般都是自定义的,所有采集的数据大部分都是没有统一的。字段划分体系的方法不同,采集的信息也有所不同,所以在归属上没有更明确的整理要求,标准的不同才导致数据分析时出现问题,无法准确识别有用的岗位信息。岗位类型通过预处理关键词,把数据处理的简洁且详细,由此可通过聚类分析方法来细化其归属。本文通过分析481条职位类型的企业信息,可知企业的经验要求、学历要求、薪酬分布、城市分布、企业福利等岗位信息,得出岗位数据的类型分类。

主要岗位类型包括技术类岗位的前端开发、后台开发、软硬件开发、测试、运维、DBA等,技术类的岗位要求都较高,比如学历要求、经验要求,随之而来的薪酬也相对较高。与之要求类似的还有设计类,设计类岗位的UI设计、交互设计、视觉设计、用户研究等,薪酬方面跟技术岗不相上下。运营类岗位的内容、产品、数据、用户、商家、推广、编辑、客服等,运营类的岗位经验和学历要求都处于比较低的位置,简称“低门槛”。“低门槛”也包括市场销售类的岗位,主要是一些不需要技术类的岗位,像策划、营销、推广、销售、品牌、公关等。类似的还有职能类岗位的人力、行政、财务、法务等。

3 步骤实施

3.1数据查看

通过网络爬虫爬取前程无忧网站的招聘信息,进行整理,然后从招聘岗位、薪资待遇、工作地点、企业福利和企业基本信息这几方面的数据,对大中型城市的互联网行业职位数据做出研究与分析,对选择互联网行业的广大择业人员起到一个初步的指导。本文使用matplotlib来进行数据分析和数据可视化。

attribute_text岗位要求列里主要包含经验要求和学历要求,通过’/’来把经验和学历分开,分成两行,以便后期的数据分析及可视化,如图3.1所示:

.png)

3.2数据分析及数据可视化

以下的过程都是已经经过预处理的数据分析及数据可视化。

3.2.1招聘岗位层次数据分析

通过绘制柱形图设置柱条的宽度和颜色,在分析和可视化时,有些是异地招聘,需要过滤掉。结合城市分布可以知道互联网行业还是主要分布在经济发展较好的城市,比如北京、上海、广州等等。数据可视化可以很清楚的看到互联网行业的大概分布情况,提供了较多岗位的有上海、深圳、广州、武汉,其他城市的互联网行业招聘岗位数量也比较可观,比如杭州、成都、武汉、南京。

3.2.2薪酬数据分析

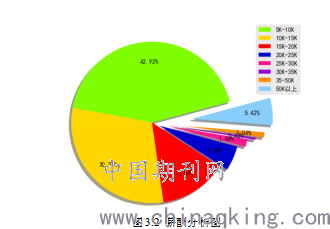

通过薪酬分布的数据分析,采用饼图展示,可以更加具体的看出薪酬的分布,薪酬分布主要是计算岗位数据的薪酬,确定薪酬数据信息处理为多少K/月,而不是多少万/月,因为会容易导致数据的混乱,按照一定的规律划分薪酬区间,由饼图来统计薪酬分布的情况。根据招聘岗位薪酬分析,给的薪酬所占的比例可知在5K-10K和10K-15K的区间最大,紧接着是15K-20K区间,占比最少的是30K-35K区间,50K以上的高薪资岗位也有一定的比例。如图3.2所示:

3.2.3学历要求分析

结合学历分析图,可看出本文“大专”和“本科”学历的需求占比较多,运营岗和职能岗对“大专”和“本科”学历的需求较多,技术和设计类对本科学历的人才需求也是占一定的比例,所有造成了本文的学历分析结果是本科学历比例最高。技术、设计类对“硕士”及“博士”的需求也是必不可少的,这些类别的岗位在需求上一直都是名列前茅,所以技术和设计类称得上是热门类岗位。从职位类型方面来看,“硕士”“博士”主要需求是在技术方面,市场与销售类别和运营岗对“硕士”的需求几乎没有,需求集中在“大专”学历;职能岗的学历要求也不高,不需要要求技术的能力,大部分是其主要工作内容是行政、人力等基础性事务,这些岗位的工作都比较轻松,而“硕士”一类的比例是高层管理人员占比较大,需要一定知识能力,故有一定的两级分化性。

3.2.4 经验要求分析

通过经验要求分析可知,由于得到的数据在工作经验列里不统一,所以统计时需要做特殊整理,变得规范化。经验要求处理是在校生\应届生和本科为无需经验,硕士为1-2年经验,博士为3-4年经验,技术岗一般要求1-2年工作经验,但大多数刚毕业的学生,工作经验大部分都很少,所以本文的无需经验要求占比是最多的,因为爬取的数据中应届生和本科生最多,而应届生和本科生均隶属于无需经验,所以无需经验要求占比最大,“1-2年”和“3-4年”的招聘需求仅次于无需经验要求,这代表硕士和博士在人才需求上也占一定的比例,硕士和博士毕业出来一般都是技术岗。互联网行业发展的越发快速,大家都力求在互联网找到适合自己的定位,改变原本的生活方向,因此一些互联网用户开始在网上经营自己的社交网站,这些产业链自起一门职位,形成新一代的新媒体运营。

3.2.5 企业行业分布及职位福利

查看招聘公司所属行业的分布情况,通过词云图展示,可知互联网公司所属的工作职能有计算机服务、计算机软件、网络设备、游戏和电子商务等等,也可看出公司类型有民营、外资、上市、国企。

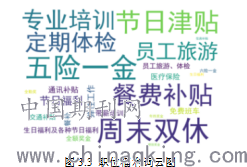

根据查看招聘岗位的职位福利,由词云图展示,由出现频率较高的有五险一金、周末双休、专业培训、节日津贴、餐饮补贴等关键词中可分析出职位福利,几乎每家企业都有周末双休和五险一金的福利,由图3.3所示:

总结

基于大数据背景下改变传统调研方式,使用面向python语言的网络爬虫技术、数据分析以及数据可视化,从网页招聘数据中分析出有价值的信息,给予人们一份关于互联网行业的分析报告,让企业了解行业的发展来改变企业的发展方向,高校明确企业的发展方向,确定人才培养方案,求职者从中掌握互联网行业企业的发展和企业人才需求特点,从本文的第三部分和第四部分的对比,随着大数据和人工智能的发展,岗位需求和人才需求都随着变化。

参考文献

[1]沈苏彬,范曲立,宗平.物联网的体系结构与相关技术研究[J].南京邮电大学学报(自然科学版)(6):1-11.

[2]詹翠芬.基于数据挖掘的互联网行业岗位类型分析[J].计算机产品与流通,2018(07):138-140.

[3]郭丽蓉.基于Python的网络爬虫程序设计[J].电子技术与软件工程,2017,000(023):248-249.

[4]云绍辉.互联网时代职位分析新思路[J].企业管理,2016,No.416(04):97-99.

[5]谭梦妮,沈舒凡,徐昕蓓."互联网+"背景下市场营销岗位变迁及职业能力要求研究[J].商场现代化,2017,17(v.37;No.145):59-60.